| Статистика |

Онлайн всего: 1 Гостей: 1 Пользователей: 0 |

|

Основные парадигмы нейронных сетей

1 Введение

Нейронные сети, или точнее, искусственные нейронные сети, представляют собой технологию, уходящую корнями во множество дисциплин: нейрофизиологию, математику, статистику, физику, компьютерные науки и технику. Они находят свое применение в таких разнородных областях, как моделирование, анализ временных рядов, распознавание образов, обработка сигналов и управление благодаря одному важному свойству – способности обучаться на основе данных при участии учителя или без его вмешательства.

1.1 Что такое нейронные сети

Исследования по искусственным нейронным сетям связаны с тем, что способ обработки информации человеческим мозгом в корне отличается от методов, применяемых обычными цифровыми компьютерами. Мозг представляет собой чрезвычайно сложный, нелинейный, параллельный компьютер (систему обработки информации). Он обладает способностью организовывать свои структурные компоненты, называемые нейронами (neuron), так чтобы они могли выполнять конкретные задачи (такие как распознавание образов, обработку сигналов органов чувств, моторные функции) во много раз быстрее, чем могут позволить самые быстродействующие современные компьютеры.

1.2 Свойства искусственных нейронных сетей

Обучение

Искусственные нейронные сети могут менять свое поведение в зависимости от внешней среды. Этот фактор в большей степени, чем любой другой, ответствен за тот интерес, который они вызывают. После предъявления входных сигналов (возможно, вместе с требуемыми выходами) они самонастраиваются, чтобы обеспечивать требуемую реакцию.

Обобщение

Отклик сети после обучения может быть до некоторой степени нечувствителен к небольшим изменениям входных сигналов. Эта внутренне присущая способность видеть образ сквозь шум и искажения жизненно важна для распознавания образов в реальном мире. Она позволяет преодолеть требование строгой точности, предъявляемое обычным компьютером, и открывает путь к системе, которая может иметь дело с тем несовершенным миром, в котором мы живем.

Абстрагирование

Некоторые из искусственных нейронных сетей обладают способностью извлекать сущность из входных сигналов. Например, сеть может быть обучена на последовательность искаженных версий буквы «А». После соответствующего обучения предъявление такого искаженного примера приведет к тому, что сеть породит букву совершенной формы. В некотором смысле она научится порождать то, что никогда не видела.

1.3 Надежность

Подобно людям, структуру мозга которых они копируют, искусственные нейронные сети сохраняют в определенной мере непредсказуемость. Единственный способ точно знать выход состоит в испытании всех возможных входных сигналов. В большой сети такая полная проверка практически неосуществима и должны использоваться статистические методы для оценки функционирования. В некоторых случаях это недопустимо.

1.4 Искусственный нейрон – модель естественного нейрона

В основу нейроинформатики положено моделирование клетки естественного нейрона живых организмов. Несмотря на то, что на самом деле связь с биологией слаба и зачастую несущественна, искусственные нейронные сети продолжают сравниваться с мозгом. По той причине, что развитие искусственных нейронных сетей вдохновляется биологией, имеет смысл рассмотреть естественный прототип.

Как и любая иная клетка, нейрон имеет тело со стандартным набором органелл, называемое сомой. Внутри сомы находится ядро. Самым главным отличием нейронов от других клеток является то, что они не делятся и имеют множество отростков, соединяющих один нейрон с другими. Различают входные отростки (дендриты) и один очень длинный выходной отросток – аксон (рис. 2). Число входов у нейронов может быть очень велико (до одной тысячи), выход всегда один, однако он имеет разветвления (колатералы), оканчивающиеся синапсами.

Рис. 1. Структура биологической нервной клетки (нейрона)

Соответственно, выход каждого нейрона влияет по-разному на входы последующих нейронов. Один и тот же выходной сигнал некоторого аксона может выступать и как возбуждающий, и как тормозящий сигнал для последующих нейронов.

1.5 Модель формального кибернетического нейрона

Формальный нейрон (рис. 3) состоит из 3 логических блоков: входы, функция преобразования. Множество входных сигналов: (x1, x2,…, xn) в совокупности представляют собой вектор X. Каждый вес (w1, w2,…, wn) соответствует «силе» одной биологической синаптической связи и обозначается вектором W. Далее идет суммирующий блок, соответствующий телу биологического элемента, складывает взвешенные входы алгебраически, создавая выход NET. Сигнал NET, преобразуется активационной функцией F и дает выходной нейронный сигнал Y.

Рис. 2 Искусственный нейрон

На рис. 2 блок, обозначенный f, принимает сигнал NET и выдает сигнал Y. Блок f называется «сжимающей» функцией. Он сужает диапазон изменения величины NET так, что при любых значениях NET, значения Y принадлежат некоторому конечному интервалу.

2 Персептрон

Персептрон – это первая математическая модель восприятия информации мозгом, предложенная Фрэнком Розенблаттом в 1957 году и реализованная в виде электронной машины «Марк-1» в 1960 году. Несмотря на свою простоту, персептрон способен обучаться и решать довольно сложные задачи. Основная математическая задача, с которой он справляется — это линейное разделение любых нелинейных множеств, так называемое обеспечение линейной сепарабельности.

Персептрон состоит из трёх типов элементов, а именно: поступающие от сенсоров сигналы передаются ассоциативным элементам, а затем реагирующим элементам. Таким образом, персептроны позволяют создать набор «ассоциаций» между входными стимулами и необходимой реакцией на выходе. В биологическом плане это соответствует преобразованию, например, зрительной информации в физиологический ответ от двигательных нейронов. Согласно современной терминологии, персептроны могут быть классифицированы как искусственные нейронные сети:

с одним скрытым слоем

с пороговой передаточной функцией;

с прямым распространением сигнала.

Хотя один нейрон и способен выполнять простейшие процедуры распознавания, сила нейронных вычислений проистекает от соединений нейронов в сетях. Простейшая сеть состоит из группы нейронов, образующих один слой(рис. 3). Вершины-круги слева служат лишь для распределения входных сигналов. Они не выполняют каких- либо вычислений, и поэтому не будут считаться слоем. По этой причине они обозначены кругами, чтобы отличать их от вычисляющих нейронов, обозначенных квадратами. Каждый элемент из множества входов Х отдельным весом соединен с каждым искусственным нейроном. А каждый нейрон выдает взвешенную сумму входов в сеть. В искусственных и биологических сетях многие соединения могут отсутствовать, все соединения показаны в целях общности.

Удобно считать веса элементами матрицы W. Матрица имеет т строк и п столбцов, где m – число входов, а n – число нейронов. Таким образом, вычисление выходного вектора N, компонентами которого являются выходы Y нейронов, сводится к матричному умножению N = XW, где N и Х – векторы-строки.

Рис. 3. Однослойная сеть

Достоинства

Доказательство теоремы обучения персептрона показало, что персептрон способен научиться всему, что он способен представлять. Важно при этом уметь различать представляемость и обучаемость. Понятие представляемости относится к способности персептрона (или другой сети) моделировать определенную функцию. Обучаемость же требует наличия систематической процедуры настройки весов сети для реализации этой функции.

Недостатки

Один из самых пессимистических результатов Минского показывает, что однослойный персептрон не может воспроизвести такую простую функцию, как “Исключающее или”. Это связано с тем, что однослойная сеть может работать только с линейно разделимыми (сепарабельными) множествами обучающих векторов.

2.1 Многослойный персептрон

Вероятно, архитектура многослойных нейронных сетей используется сейчас наиболее часто. Она была предложена еще в работах Розенблатта. Обычно сеть состоит из множества сенсорных элементов (входных узлов), которые образуют входной слой и одного или нескольких скрытых слоев вычислительных нейронов и одного выходного слоя.

Многослойными персептронами называют нейронные сети прямого распространения. Входной сигнал в таких сетях распространяется в прямом направлении, от слоя к слою. Многослойный персептрон в общем представлении состоит из следующих элементов:

множества входных узлов, которые образуют входной слой;

одного или нескольких скрытых слоев вычислительных нейронов;

одного выходного слоя нейронов.

Многослойный персептрон представляет собой обобщение однослойного персептрона Розенблатта.

Каждый нейрон сети должен иметь нелинейную функцию активации. Важно подчеркнуть, что такая нелинейная функция должна быть гладкой (т.е. всюду дифференцируемой), в отличие от жесткой пороговой функции, используемой в персептроне Розенблатта. Самой популярной формой функции, удовлетворяющей этому требованию, является сигмоидальная.

Обучение

Процедура обратного распространения (градиентный спуск)

Стохастические методы

Достоинства

Универсальность (Решена проблема с линейной разделимостью обучающих множеств)

Высокая степень связности обеспечивает большую вычислительную мощность

Недостатки

Высокая степень связности являются причиной неполноты современных знаний о поведении такого рода сетей

Длительное время обучения

Необходимость большого числа обучающих множеств

2.2 Градиентный спуск (обучение)

Целью обучения сети является нахождение такого множества ее весов, при подстановке которых обучаемая сеть соответствовала бы всем обучающим парам. Условия этой задачи можно представить, если величину δ и значения весов принять за координаты гиперплоскости. Тогда решение задачи сводится к нахождению глобального минимума на этой гиперплоскости.

Градиентный спуск - это систематический метод для обучения многослойных искусственных нейронных сетей. Он представляет собой метод нахождения локального экстремума (минимума или максимума) функции с помощью движения вдоль градиента и является наиболее простой в реализации из всех методов локальной оптимизации. Имеет довольно слабые условия сходимости, но при этом скорость сходимости достаточно мала (линейна).

В качестве активационной функции обычно используется сигмоидальная, так как данная функция имеет простую производную:

Алгоритм данного метода представляет собой последовательность операций:

1. Выбрать очередную обучающую пару из обучающего множества; подать входной вектор на вход сети.

2. Вычислить выход сети.

3. Вычислить разность между выходом сети и требуемым выходом (целевым вектором обучающей пары).

4. Подкорректировать веса сети так, чтобы минимизировать ошибку.

5. Повторять шаги с 1 по 4 для каждого вектора обучающего множества до тех пор, пока ошибка на всем множестве не достигнет приемлемого уровня.

Достоинства

Возможность обучения многослойных сетей

Недостатки

Неопределённо долгий процесс обучения

Паралич сети - значительно замедляется или полностью останавливается обучение

Локальные минимумы - система не может выбраться из впадины на гиперплоскости

Размер шага. Из доказательства сходимости коррекция весов предполагается бесконечно малой, что это неосуществимо на практике

Временная неустойчивость. Сеть, подстраиваясь под следующую обучающую пару, может забыть предыдущую, таким образом, процесс обучения может никогда не сойтись, бесцельно блуждая или сильно осциллируя. В этом смысле алгоритм обратного распространения ошибки не похож на биологические системы.

2.3 Стохастические методы (обучение)

Стохастические методы полезны как для обучения искусственных нейронных сетей, так и для получения выхода от уже обученной сети; они приносят большую пользу, позволяя исключать локальные минимумы в процессе обучения. Суть стохастических методов заключается в выполнении псевдослучайных изменений величин весов, сохраняя изменения, которые ведут к улучшениям.

Последовательность операций данного алгоритма обучения:

1. Выбрать вес случайным образом и подкорректировать его на небольшое случайное Предъявить множество входов и вычислить получающиеся выходы.

2. Сравнить эти выходы с желаемыми выходами и вычислить величину разности между ними. Общепринятый метод состоит в нахождении разности между фактическим и желаемым выходами для каждого элемента обучаемой пары, возведение разностей в квадрат и нахождение суммы этих квадратов. Целью обучения является минимизация этой разности, часто называемой целевой функцией.

3. Выбрать вес случайным образом и подкорректировать его на небольшое случайное значение. Если коррекция помогает (уменьшает целевую функцию), то сохранить ее, в противном случае при определенной вероятности вернуться к первоначальному значению веса.

4. Повторять шаги с 1 до 3 до тех пор, пока сеть не будет обучена в достаточной степени.

В качестве объясняющей аналогии предположим, что есть шарик на поверхности в коробке. Если коробку сильно потрясти в горизонтальном направлении, то шарик будет быстро перекатываться от одного края к другому. Нигде не задерживаясь, в каждый момент шарик будет с равной вероятностью находиться в любой точке поверхности.

Если постепенно уменьшать силу встряхивания, то будет достигнуто условие, при котором шарик будет на короткое время «застревать» в точке В. При более слабом встряхивании шарик будет на короткое время останавливаться как в точке А, так и в точке В. При непрерывном уменьшении силы встряхивания будет достигнута критическая точка, когда сила встряхивания достаточна для перемещения шарика из точки А в точку В, но недостаточна для того, чтобы шарик мог вскарабкаться из В в А. Таким образом, окончательно шарик остановится в точке глобального минимума, когда амплитуда встряхивания уменьшится до нуля.

Достоинства

Позволяет избежать проблем связанных с локальными минимумами

Недостатки

Паралич сети

Время сходимости может в 100 раз превышать время для алгоритма обратного распространения

2.4 Когнитрон

Основываясь на текущих знаниях анатомии и физиологии мозга, был разработан когнитрон, гипотетическая модель системы восприятия человека. Когнитрон — это искусственная нейронная сеть на основе принципа самоорганизации. Своей архитектурой когнитрон похож на строение зрительной коры, имеет иерархическую многослойную организацию, в которой нейроны между слоями связаны только локально.

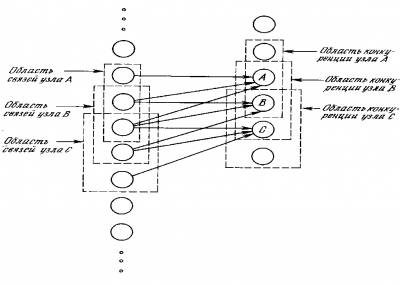

Когнитрон состоит из иерархически связанных слоев нейронов двух типов — тормозящих и возбуждающих. Состояние возбуждения каждого нейрона определяется соотношением его тормозящих и возбуждающих входов. Синаптические связи идут от нейронов одного слоя (далее слоя 1) к следующему (слою 2). Относительно данной синаптической связи соответствующий нейрон слоя 1 является пресинаптическим, а нейрон второго слоя — постсинаптическим (Рис. 4). Постсинаптические нейроны связаны не со всеми нейронами 1-го слоя, а лишь с теми, которые принадлежат их локальной области связей. Области связей близких друг к другу постсинаптических нейронов перекрываются, поэтому активность данного предсинаптического нейрона будет сказываться на все более расширяющейся области постсинаптических нейронов следующих слоев иерархии.

Рис.4. Пресинаптические и постсинаптические нейроны.

Когнитрон конструируется в виде слоев нейронов, соединенных синапсами. Пресинаптический нейрон в одном слое связан с постсинаптическим нейроном в следующем слое. Имеются два типа нейронов: возбуждающие узлы, которые стремятся вызвать возбуждение постсинаптического узла, и тормозящие узлы, которые тормозят это возбуждение. Возбуждение нейрона определяется взвешенной суммой его возбуждающих и тормозящих входов, однако в действительности механизм является более сложным, чем простое суммирование.

Данная нейронная сеть одновременно является как моделью процессов восприятия на микроуровне, так и вычислительной системой, применяющейся для технических задач распознавания образов.

На рис. 5 показано, что области связи соседних узлов значительно перекрываются. Это расточительное дублирование функций оправдывается взаимной конкуренцией между ближайшими узлами. Даже если узлы в начальный момент имеют абсолютно идентичный выход, небольшие отклонения всегда имеют место; один из узлов всегда будет иметь более сильную реакцию на входной образ, чем соседние. Его сильное возбуждение будет оказывать сдерживающее воздействие на возбуждение соседних узлов, и только его синапсы будут усиливаться; синапсы соседних узлов останутся неизменными.

Рис.5. Область связи с областью конкуренции

Достоинства

Когнитрон является одной из лучших конфигураций сети в распознавании образов

Недостатки

Узкая специализированность

Сложная система требует существенных вычислительных ресурсов

2.5 Рекуррентные персептроны

На первый взгляд похож на обычный персептрон, единственное существенное отличие состоит в том, что его выходы попадают ему же на входы, и участвуют в обработке уже следующего входного вектора. То есть, в случае рекуррентного персептрона имеет место не набор отдельных, ничем не связанных образов, а некоторый процесс, и значение имеют не только сами входы, но и то, в какой последовательности они поступают. Из-за этого возникают отличия в методе обучения — используется то же самое обратное распространение ошибки, но для того, чтобы ошибка попала по рекуррентной связи в прошлое, используются разные ухищрения (если подойти к задаче «в лоб» — то возникнет проблема ухода ошибки на бесконечное число циклов назад). В остальном же ситуация похожа на обычный персептрон — для обучения нужно иметь достаточно длинную последовательность пар вход-выход, которую нужно много раз прогнать через сеть, чтобы ее обучить (или же иметь под рукой математическую модель искомого процесса, которую можно гонять во всевозможных условиях, и в реальном времени давать результаты сети для обучения).

Рис.6. Рекуррентный персептрон

Достоинства

Сеть очень хороша для работы с динамическими процессами

Недостатки

Если сеть не работает, понять, в чем проблема — очень затруднительно

В процессе обучения может перейти в самовозбуждение (когда сигнал, полученный с выхода, забивает все, что приходит по входам), если решение все же получено — сложно понять, можно ли добиться лучших результатов, и каким путем.

2.6 Спайковые сети

Это особый класс сетей, в которых сигнал представлен не вещественным числом, как во всех ранее рассмотренных сетях, а набором импульсов (спайков) одинаковой амплитуды и длительности, и информация содержится не в амплитуде, а в интервалах между импульсами, в их паттерне. Спайковые нейроны на выходе генерируют спайки, либо одиночные (если суммарный вход не очень большой), или пакеты (если суммарный вход достаточно велик). Этот тип сетей почти полностью копирует процессы, проходящие в мозгу человека. Единственное серьезное отличие заключается в том, что для обучения не придумано ничего лучше правила Хебба. Оно звучит примерно так: если второй нейрон сработал сразу после первого, то связь от первого ко второму усиливается, а если сразу перед первым — то ослабевает. Для этого правила был придуман ряд небольших усовершенствований, но, к сожалению, повторить свойства мозга в области обучения пока толком не получилось.

Сети такого типа умеют приспосабливать для решения различных задач, решаемых другими сетями, но редко результаты оказываются существенно лучше. В большинстве случаев удается только повторить уже достигнутое.

Достоинства

Интересны для изучения как модели биологических сетей.

Недостатки

Почти любое практическое применение выглядит необоснованно, сети других типов справляются не хуже.

Перспективы: моделирование масштабных спайковых сетей в ближайшие годы, вероятно, даст много ценной информации о психических расстройствах, позволит классифицировать нормальный и ненормальный режимы работы различных отделов мозга. В более отдаленной перспективе, после создания подходящего алгоритма обучения, такие сети по функциональности сравняются или даже превзойдут другие типы нейросетей, а еще позднее на их основе можно будет собирать структуры, пригодные для прямого подключения к биологическому мозгу, для расширения возможностей интеллекта.

3 Заключение

В процессе выполнения домашнего задания было произведено ознакомление с основными парадигмами построения нейронных сетей, а так же методами их обучения и оптимизации. Подводя итоги, можно с уверенностью сказать, что на сегодняшний день нейронные сети являются одним из приоритетных направлений исследований в области искусственного интеллекта.

Список источников

1. Саймон Хайкин: “Нейронные сети полный курс “

2. Ф. Уоссермен: “Нейрокомпьютерная техника: Теория и практика”

3. http://ru.wikipedia.org

4. http://itmmbs.st.pgta.ru/html/INS.htm

5. http://www.aiportal.ru

6. http://habrahabr.ru/post/83781/

Источник: http://нейсети |

Категория: Рефераты (курсы КП, ПК, ИТ и Сети) | Добавил: Solitaire (21.12.2013)

| Автор: Барсов Владислав

|

| Просмотров: 2908

| Рейтинг: 0.0/0 |

Добавлять комментарии могут только зарегистрированные пользователи. [ Регистрация | Вход ] |

|