РЕФЕРАТ

Работа состоит из 16 страниц. В ней содержится 5 рисунков, 1 таблица. При выполнении работы было использовано 9 источников информации.

Ключевые слова:

ПО – Программное обеспечение; ВО – Вычислительная система; ЭВМ – Электро вычислительная машина;

Цель работы:

Определить основные законы сетей и понять их смысл и значение для самих сетей.

ГЛОССАРИЙ

Кэш – промежуточный буфер с быстрым доступом, содержащий информацию, которая может быть запрошена с наибольшей вероятностью.

Сетевая модель OSI – базовая эталонная модель взаимодействия открытых систем.

Стандарт IEEE 802 – группа стандартов семейства IEEE, касающихся локальных вычислительных сетей и сетей мегаполисов.

Технология Ethernet - понимают пакетную технологию передачи данных преимущественно ЛКС.

AON (англ. Application Oriented Networking) – концепция, принимающая ориентированность на приложения средств «интеллектуализации» сетевой инфраструктуры.

IEEE (англ. Institute of Electrical and Electronics Engineers) – международная некоммерческая организация специалистов в области техники, мировой лидер в области разработки стандартов по радиоэлектронике и электротехнике.

IP (англ. Internet Protocol) - маршрутизируемый протокол сетевого уровня стека TCP/IP. Неотъемлемой частью протокола является адресация сети.

SONA (англ. Service-Oriented Network Architecture) – концепция сетевой архитектуры, ориентированной на сервисы.

ВВЕДЕНИЕ

Многие законы компьютерного мира имеют прямое отношение к сетевым технологиям. Действительно, управление сетью происходит на основе сетевых протоколов и интерфейсов. Не обходится без программного обеспечения (ПО) и отдельный узел сети – компьютер. Значит, нужно рассматривать законы, которые касаются software.

Существуют законы, характерные для компьютеров и процессоров, из которых может быть «собран» компьютер или даже целая вычислительная система (ВС). ВС ведь тоже может быт узлом сети.

Для создания элементной базы (в данном случае имеются в виду интегральные микросхемы разных типов) компьютеров разных типов тоже есть свои законы и принципы.

И, наконец, «чисто» физические ограничения, которые влияют, в конечном итоге, на ключевые характеристики сетей.

Попробуем привести примеры некоторые из таких законов, правил, ограничений. В некоторых случаях законы компьютерного мира носят довольно строгий характер и описываются математическими формулами. Иногда такие законы представляют характер эмпирические обобщения или вовсе формулируются качественно. Есть даже шуточные законы…

Начнем «сверху», т.е. с программного обеспечения, постепенно спускаясь вниз к физике элементной базы.

ЗАКОН ВИРТА

Закон Вирта — это полушутливое высказывание, популяризированное Никлаусом Виртом в 1995 году. Звучит оно так: «Программы становятся медленнее более стремительно, чем компьютеры становятся быстрее»

Вирт указал, что выражение впервые было сформировано Мартином Райзером, который в предисловии к его книге об операционной системе Оберон написал: «Есть мнение, что прогресс в аппаратной части излечит все недостатки программ, однако внимательный наблюдатель может заметить, что программы перерастают компьютеры в размерах и медлительности» (англ. The hope is that the progress in hardware will cure all software ills. However, a critical observer may observe that software manages to outgrow hardware in size and sluggishness.).

Скорость работы компьютеров становится выше в соответствии с законом Мура. Закон Вирта утверждает, что увеличение производительности аппаратной части ещё не означает ускорения работы как таковой.

Закон также иногда называется Законом Пейджа, в честь Ларри Пейджа, основателя Google, который упомянул его в своём выступлении. Впервые о нём упомянул Сергей Брин на конференции Google I/O в 2009 году.[1]

Это замечают все, кто занимается обработкой сложных изображений, аудио, видео, моделированием больших систем, анализом баз данных...

Многие могут вспомнить время, как человечество с замиранием сердца смотрело на компьютер с частотой 150 МГц. После 10 Мгц это казалось просто немыслимо быстрым. Сейчас 8 процессоров по 3 Ггц каждый и нам этого мало.

Даже когда мы видим характеристики университетских суперкомпьютеров, где сотни быстрых процессоров работают параллельно, то вскоре все равно мы ставим цели достичь скоростей в сто раз больше.

Как моделировать работу мозга человека?

Как моделировать образование кластеров в жидкой воде?

Как моделировать движение белковой молекулы в окружении молекул воды и лекарства?

ЗАКОН ГЕЙТСА

«Программы становятся в два раза медленнее каждые полтора года».

Закон Гейтса — это вариант закона Вирта, названный в честь основателя Microsoft Билла Гейтса. Это шутливое наблюдение, утверждающее, что скорость программного обеспечения уменьшается на половину каждые полтора года, что сводит на нет все преимущества закона Мура. Это может происходить по нескольким причинам: добавление избыточных ненужных функций, плохой код, нежелание программистов дорабатывать программы и плохой менеджмент или частая смена команды.[1]

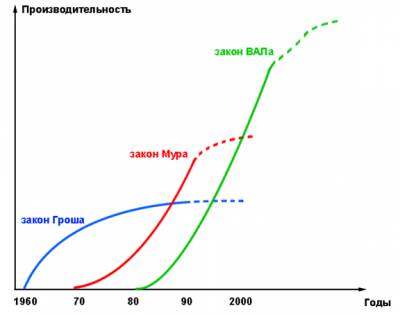

ЗАКОН ГРОША

Законом Гроша называют следующее замечание о производительности компьютеров, сделанное Хербом Грошем в 1965 году: «Существует фундаментальное правило, которое я скромно называю законом Гроша: получение добавочной экономии есть только квадратный корень от увеличения в скорости — то есть, чтоб сделать вычисления в 10 раз дешевле, вы должны сделать это в 100 раз быстрее».

Это изречение чаще формулируется так: «Производительность компьютера увеличивается как квадрат стоимости. Если компьютер A стоит в два раза дороже, чем компьютер B, то вы должны ожидать, что компьютер A в четыре раза быстрее, чем компьютер B».

Закон также может быть истолкован в том значении, что компьютеры представляют собой пример экономии от масштаба: чем более дорог компьютер, тем отношение производительность/цена для него линейно лучше. Это означает, что недорогие компьютеры не могут конкурировать на рынке, поскольку их вычисления дороже. В конце концов, несколько огромных машин будут обслуживать вычислительные запросы всего мира. Предположительно, это могло быть побуждением для предсказания Томаса Дж. Уотсона, на то время, что общий глобальный рынок вычислительных задач составляет пять ЭВМ.

Современный пример: этот закон гласит, для того, чтобы иметь компьютер в сто раз более мощный, чем современный PC владельцу пришлось бы заплатить только в десять раз больше.

Сегодня актуальность закона Гроша является обсуждаемой. Пол Штрассман утверждал в 1997 году, этот закон Гроша в настоящее время «полностью опровергнут» и служит «напоминанием, что история экономики вычислительных систем изобиловала неподдерживаемыми и неправильными представлениями». Грош сам заявил, что закон являлся более полезным в 1960-х и 1970-х годах, чем сегодня. Он изначально предназначался, чтобы закон был «средством оценки цены на вычислительные услуги». Грош также пояснил, что сегодняшнее наличие изощренных способов исследования стоимости построения компьютерных систем, означает, что его закон имеет ограниченную применимость для современных ИТ-менеджеров.

Для кластеров, первоначальный закон Гроша предполагает, что если кластер содержит 50 машин, и к нему добавлено еще 50 машин, (удвоение стоимости), то в результате 100-машинный кластер будет иметь учетверенную вычислительную мощность, что, очевидно, неверно. Напротив, даже линейное увеличение производительности — 100-машинный кластер сделать вдвое более мощным, чем 50-машинный кластер, будет проблемой.

Когда Google определялся с архитектурой компьютерной системы для своей услуги веб-поиска, то пришёл к выводу, что расширение масштабов кластеров из больших и средних компьютеров (мейнфреймов) при росте бизнеса было бы слишком дорогим; и потому выбрал для вычислительных массивов дешёвые процессоры и диски .[2]

ЗАКОН АМДАЛА

Зако́н Амдала (англ. Amdahl's law, иногда также Закон Амдаля-Уэра) — иллюстрирует ограничение роста производительности вычислительной системы с увеличением количества вычислителей. Джин Амдал сформулировал закон в 1967 году, обнаружив простое по существу, но непреодолимое по содержанию ограничение на рост производительности при распараллеливании вычислений: «В случае, когда задача разделяется на несколько частей, суммарное время её выполнения на параллельной системе не может быть меньше времени выполнения самого длинного фрагмента». Согласно этому закону, ускорение выполнения программы за счёт распараллеливания её инструкций на множестве вычислителей ограничено временем, необходимым для выполнения её последовательных инструкций.

Пусть необходимо решить некоторую вычислительную задачу. Предположим, что её алгоритм таков, что доля от общего объёма вычислений может быть получена только последовательными расчётами, а, соответственно, доля может быть распараллелена идеально (то есть время вычисления будет обратно пропорционально числу задействованных узлов ). Тогда ускорение, которое может быть получено на вычислительной системе из процессоров, по сравнению с однопроцессорным решением не будет превышать величины

Таблица показывает, во сколько раз быстрее выполнится программа с долей последовательных вычислений при использовании процессоров.

Таблица 1. Зависимость вычислений от процессоров

\ 10 100 1000

0 10 100 1000

10% 5.263 9.174 9.910

25% 3.077 3.883 3.988

40% 2.174 2.463 2.496

Из таблицы видно, что только алгоритм, вовсе не содержащий последовательных вычислений ( ), позволяет получить линейный приростпроизводительности с ростом количества вычислителей в системе. Если доля последовательных вычислений в алгоритме равна 25 %, то увеличение числа процессоров до 10 дает ускорение в 3,077 раза, а увеличение числа процессоров до 1000 даст ускорение в 3,988 раза.

Отсюда же очевидно, что при доле последовательных вычислений общий прирост производительности не может превысить . Так, если половина кода — последовательная, то общий прирост никогда не превысит двух.

Закон Амдала показывает, что прирост эффективности вычислений зависит от алгоритма задачи и ограничен сверху для любой задачи с . Не для всякой задачи имеет смысл наращивание числа процессоров в вычислительной системе.

Более того, если учесть время, необходимое для передачи данных между узлами вычислительной системы, то зависимость времени вычислений от числа узлов будет иметь максимум. Это накладывает ограничение на масштабируемость вычислительной системы, то есть означает, что с определенного момента добавление новых узлов в систему будет увеличивать время расчёта задачи.[3]

ЗАКОН МЕТКАЛФА

Закон Меткалфа гласит, что полезность сети пропорциональна квадрату численности пользователей этой сети ≈n2. Это происходит из того факта, что количество уникальных связей в сети с количеством узлов (n) может быть математически выражено треугольным числом n(n − 1)/2, которое асимптотически приближается к n2/2.

Этот закон был впервые сформулирован Робертом Меткалфом в отношении Ethernet. Закон описывает такое понятие как Сетевой эффект и используется в многоуровневом сетевом маркетинге, в социальных сетях и маркетинге как таковом.

Закон вызвал бум появления доткомов. На практике это означает, что если одна связь в сети приносит человеку 1 условную единицу пользы, то при группе в 10 человек эта польза представляет собой 45 условных единиц, 100 чел - 4950 условных единиц, и так далее, - растет в квадратичной зависимости.[4]

ЗАКОН МУРА

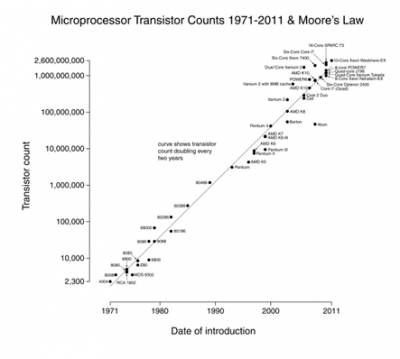

Зако́н Му́ра — эмпирическое наблюдение, изначально сделанное Гордоном Муром, согласно которому (в современной формулировке) количество транзисторов, размещаемых на кристалле интегральной схемы, удваивается каждые 24 месяца. Часто цитируемый интервал в 18 месяцев связан с прогнозом Давида Хауса из Intel, по мнению которогопроизводительность процессоров должна удваиваться каждые 18 месяцев из-за сочетания роста количества транзисторов и быстродействия каждого из них.

Рост числа транзисторов на кристалле микропроцессора показан на графике справа. Точки соответствуют наблюдаемым данным, а прямая — периоду удвоения в 24 месяца.

В 1965 году (через шесть лет после изобретения интегральной схемы) один из основателей Intel Гордон Мур в процессе подготовки выступления обнаружил закономерность: появление новых моделей микросхем наблюдалось спустя примерно год после предшественников, при этом количество транзисторов в них возрастало каждый раз приблизительно вдвое. Мур пришел к выводу, что при сохранении этой тенденции мощность вычислительных устройств за относительно короткий промежуток времени может вырасти экспоненциально. Это наблюдение получило название закона Мура.

В 1975 году Гордон Мур внёс в свой закон коррективы, согласно которым удвоение числа транзисторов будет происходить каждые два года.

Существует масса схожих утверждений, которые характеризуют процессы экспоненциального роста, также именуемых «законами Мура». К примеру, менее известный «второй закон Мура», введённый в 1998 году Юджином Мейераном, который гласит, что стоимость фабрик по производству микросхем экспоненциально возрастает с усложнением производимых микросхем. Так, стоимость фабрики, на которой корпорация Intel производила микросхемы динамической памяти ёмкостью 1 Кбит, составляла $4 млн., а оборудование по производству микропроцессора Pentium по 0,6-микрометровой технологии c 5,5 млн. транзисторов обошлось в $2 млрд.. Стоимость же Fab32, завода по производству процессоров на базе 45-нм техпроцесса, составила $3 млрд.[2].

По поводу эффектов, обусловленных законом Мура, в журнале «В мире науки» как-то было приведено такое интересное сравнение: «Если бы авиапромышленность в последние 25 лет развивалась столь же стремительно, как промышленность средств вычислительной техники, то сейчас самолёт Boeing 767 стоил бы 500 долл. и совершал облёт земного шара за 20 минут, затрачивая при этом пять галлонов (~18,9 л) топлива. Приведенные цифры весьма точно отражают снижение стоимости, рост быстродействия и повышение экономичности ЭВМ».

В 2007 году Мур заявил, что закон, очевидно, скоро перестанет действовать из-за атомарной природы вещества и ограничения скорости света.

Одним из физических ограничений на миниатюризацию электронных схем является также Принцип Ландауэра, согласно которому логические схемы, не являющиеся обратимыми, должны выделять теплоту в количестве, пропорциональном количеству стираемых (безвозвратно потерянных) данных. Возможности по отводу теплоты физически ограничены.

В последнее время, чтобы получить возможность задействовать на практике ту дополнительную вычислительную мощность, которую предсказывает закон Мура, стало необходимо задействовать параллельные вычисления. На протяжении многих лет, производители процессоров постоянно увеличивали тактовую частоту и параллелизм на уровне инструкций, так что на новых процессорах старые однопоточные приложения исполнялись быстрее без каких-либо изменений в программном коде. Сейчас по разным причинам производители процессоров предпочитают многоядерные архитектуры, и для получения всей выгоды от возросшей производительности ЦП программы должны переписываться в соответствующей манере. Однако, по фундаментальным причинам, это возможно не всегда.[5]

Рис. 1. Зависимость числа транзисторов на кристалле от времени.

ПРЕДЕЛ БРЕМЕРМАНА

Шутки шутками, но что, если задуматься об объеме такого «жесткого» диска?

В 1964 году Ханс Бреммерман опубликовал статью «Optimization through evolution and recombination», главный вывод который заключается в следующем: «Не существует системы обработки данных, искусственной или естественной, которая бы могла бы обрабатывать более чем 2×10^47 бит в секунду на грамм своей массы».

Рис. 2. Предел Бремермана.

Масса Земли оценивается примерно в 6×10^27 г, а возраст 10^10 лет, год состоит из приблизительно 3.14×10^7 секунд. Наша воображаемая компьютерная система смогла бы обработать 2,56×10^93 бит, округляя до порядка 10^93 бит.

Задачи, требующие обработки более чем 10^93 бит информации называются трансвычислительными задачами. К сожалению, комбинаторика говорит нам, что что такой предел может быть достигнут для задач даже относительно небольшого размера. Например, в распознавании образов: пусть есть массив q*q, каждый элемент которого может быть раскрашен одним из k цветов, тогда всего вариантов раскраски может быть k^(q*q). Если массив 18×18, то задача трансверсальна при двух цветах, для массива 10×10 становится трансверсальной при 9 цветах. Понятно, что рассмотреть все варианты образов сетчатки глаза, имеющий порядка миллиона светочувствительных колбочек, невозможно. Еще один пример такой задачи — тестирование микросхемы, у которой 308 входов и всего 1 выход.

Наиболее естественный способ решения трансверсальных задач — переформулировка, ослабление условий, вероятностный характер решения. Хочется верить, что все-таки появятся алгоритмы искусственного интеллекта, в частности для решения задачи распознавания образов, которые смогут позволить автоматически решать трансверсальные задачи, подобному тому, как это может делать мозг человека.

Доказательство предела Бреммермана:

Для обработки информация должна быть закодирована. Предположим, что она закодирована в виде энергетических уровней в интервале [0, E]. Пусть энергетические уровни измеряются с точностью до dE. Таким образом на всем интервале будет N = E/dE подинтервалов, каждый из которых может быть занят или нет (1 или 0).

Максимальное число битов будет равно log2 (N+1)

Для того, чтобы представить больший объем информации, необходимо сокращать dE. По принципу неопределенности Гейзенберга энергия может быть измерена с точностью до dE, если выполняется dE*dt >= h, где dt — длительность времени измерения,

h = 6.625×10^-27 эрг/с (постоянная Планка)

Получаем, N<= Edt/h

Если представить имеющуюся энергию E соответствующим количеством массы согласно формуле Эйнштейна E = mc^2

N = mc^2*dt/h

Подставив с и h, имеем

N = 1.35×10^47*m*dt

Для массы 1 г (m = 1) и времени 1с (dt = 1) получаем указанное значение

N = 2×10^47 бит

P.S. По книге Дж. Клир «Системология.Автоматизация решения системных задач»[6]

ПРАВИЛО РЕНТА

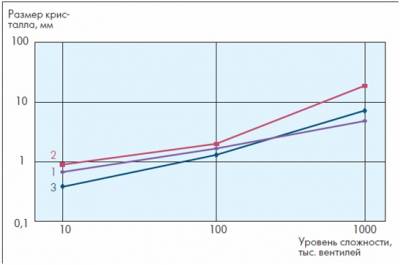

Цифровые электронные устройства, например, цифровые интегральные схемы (ИМС), в основном реализуются как цифровые автоматы, построенные на основе многочисленных логических элементов с большим числом прямых и обратных связей. Уже достаточно давно эмпирически установлена связь между уровнем сложности цифровой ИМС, числом логических элементов (N) и необходимым числом сигнальных выводов (К). Это связь называется "правилом Рента", правило №1 для микроэлектроники

Рис. 3. Зависимость размера кристалла ИМС от сложности и числа логических элементов: 1 – расчет без учета технологии изготовления ИМС; 2, 3 – расчет для технологии 0,6 и 0,25 мкм соответственно.[7]

ПРИНЦИП ЛАНДАУЭРА

Принцип Ландауэра — принцип, сформулированный в 1961 году Рольфом Ландауэром (англ.) (IBM), гласящий, что в любой вычислительной системе, независимо от ее физической реализации, при потере 1 бита информации выделяется теплота в количестве по крайней мере Джоулей:

где — константа Больцмана, — абсолютная температура вычислительной системы.

Одним из способов обойти ограничения, накладываемые этим принципом, является использование обратимых вычислений (англ.).

Выражением Шеннона — Фон-Неймана — Ландауэра (Shannon-von Neumann-Landauer, SNL) называют минимальную энергию необходимую для обработки бита Ebit (либо — минимальная высота барьера, необходимая для разделения двух состояний электрона ESNL):

при T=300 K.[8]

ЗАКОН ВАЛА

«Бывало ли вами так, что вы удобно устраивались в туалете и вдруг раздавался телефонный звонок? А не появлялся когда-нибудь ваш автобус именно в тот момент, когда вы только что закурили? Или вы взяли с собой зонт, дождь мгновенно прекратился? Возможно, именно тогда вы поняли, что все это не просто так, что существует какой-то универсальный принцип (прим.: или закон?), который так и хочется сформулировать и как-то назвать….»

«Мерфология (Мерф/и + о + логия [logos – наука; lego – говорить, собирать]) – 1) отрасль знании, посвященная тому, что идет плохо, вкривь и вкось либо не так, как надо; 2) наука об ошибках и неправильных действиях; 3) собирание пословиц, поговорок, афоризмов, максим и иных высказываний в данной области, а также их распространение....»

Из книги "Полное собрание законов Мэрфи": 2-е изд., Минск:«Попурри», 2006, 608 с.

За истекшие 27 (!) лет (с момента защиты ВАЛом диссертации на кафедре «Микроэлектроники» МИФИ в 1981 году на тему полупроводниковой памяти с «интеллектом или о процессорно-ориентированных СБИС памяти) технологии в области микроэлектроники, компьютеров и компьютерных сетей «бешено ринулись вперед. Чего только стоит один закон Мура!

Технологии волоком увлекают людей за собой, «умудряясь при этом погонять их не только криками» и пинками, но и растущим интеллектом буквально во всем: в элементной базе компьютеров, в самих компьютерах, в сетях этих компьютеров. И это привело к небывалым результатам!

Хотя многое могло «пойти и не так, как надо, или же вкривь и вкось, - одним словом, плохо…»

Нет ничего удивительного, что кроме рождения Закона Мэрфи (и Мерфологии) обязательно должен появиться и позитивный закон, например, закон ВАЛа и наука ВАЛиология…

ВАЛиология (ВАЛ/и + логия [logos – наука; lego – говорить, собирать]) – 1) отрасль знании, посвященная тому, что, что все идет по нарастающей, в лучшую сторону к всеобщему интеллекту, о котором можно было только мечтать; 2) наука о расширении интеллектуальных возможностей элементной базы компьютеров, компьютеров и сетей на их основе; 3) собирание пословиц, поговорок, афоризмов, максим и иных высказываний в данной области, а также их публичное распространение во всемирной сети.[9]

Рис. 4. Законы Гроша, Мура и ВАЛа.

ЗАКЛЮЧЕНИЕ

В связи с тем, что закон Мура выполняется уже на протяжении 50-и лет и тема того, сколько ему «еще осталось» обсуждается повсюду, хотелось бы поделиться мыслями и планами тех, кому данный закон придется утверждать и поддерживать, как минимум в ближайшие годы.

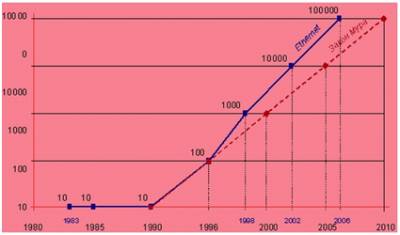

Влияние данного закона на развитие Ethernet можно увидеть на Рис. 5.

Рис. 5. Закон Мура и Ethernet.

В последнее время часто возникает вопрос: «Подходит ли к концу процесс уменьшения размеров транзисторов?» Поскольку никто не считает, что процесс совершенствования технологий может прекратиться совсем, более разумным будет вариант этого вопроса: «Становится ли технически или практически невозможным разработка и внедрение новых техпроцессов примерно каждые два года, как это предсказано законом Мура почти 50 лет назад?»

Перед тем, как ответить на данный вопрос, сначала заглянем в историю. Когда-то развитие технологий процесса производства полупроводников давалось значительно легче. Базовая архитектура МОП-транзисторов была фиксирована, и путь к разработке нового процесса был ясен и прост: уменьшить габариты, уменьшить вертикальный размер, уменьшить электрические поля и — вуаля – готов новый более быстрый и более энергоэффективный транзистор. Конечно, изобретения, типа точечных и halo(ореол) имплантаций, оксидов силицида и нитрида для затвора были необходимы для решения проблем на этом пути, но основная архитектура оставалась прежней на протяжении многих поколений. (Когда мы говорим про изобретения, давайте не будем забывать об уменьшении длины межсоединений, где предложены медные проводники и планаризация.)

Конец масштабирования?

Даже в период «расцвета» данных технологий, отраслевые эксперты предсказывали конец масштабирования. Утверждения экспертов, как «Оптическая литография достигнет своих пределов в диапазоне 0.75-0.50 мкм,» «Минимальные геометрии[транзисторов] будут достигнуты в диапазоне от 0,3 до 0,5 микрон», «рентгеновская литография понадобится при размерах менее 1 микрона,» «медные межсоединения никогда не будет работать», и «Масштабирование закончится примерно через 10 лет», были сделаны публично, и все кажутся странными спустя время.

Пожалуй, 130-нм технология была последней настоящей технологией в этой архитектуре. Начало 1990-х годов отмечено огромным изменением в этой отрасли в связи с изобретением корпорацией Intel одноосного напряженного кремния в 90-нм технологии. Это изменение отмечено использованием кремний-германиевых сплавов в истоке/стоке PMOS (р-канальный МОП) транзистора, оно открыло эпоху больших перемен в материалах в дополнение к существующим геометрическому и электрическому масштабированиям. 65-нм этап был последней возможностью, чтобы использовать «рабочую лошадку» отрасли, SiON диэлектрик затвора. Начиная с 45-нм, Intel сделал переход к экзотическому диэлектрику на основе диоксида Гафния c высоким показателем диэлектрической проницаемости k и сложной сэндвич-структурой пленок. Наконец, 22-нм этап ознаменовал конец 50-го года жизни планарного МОП транзистора и переход на tri-gate технологию 3D-транзисторов. Сегодняшнее состояние технологии напоминает транзистор конца 1980-х примерно настолько же, насколько Феррари напоминает конный экипаж.

Не только структура транзистора и материалов резко изменилась за последние десятилетия, но и цель масштабирования транзистора также изменилась. В 1980-х и 1990-х годах классическое масштабирование обеспечивало значительные улучшения в скорости транзистора для работы микропроцессоров на более высоких рабочих частотах. Но мы платили цену за очень высокую плотность мощности все более высокими ее утечками. 2000-е годы открыли эпоху, когда предел плотности мощности и рыночный спрос на мобильные компьютеры изменили фокус транзисторных технологий с повышенной производительности к уменьшенному энергопотреблению. Современные компьютеры, являются ли они высокопроизводительными серверами или маломощными мобильными телефонами, все требуют повышения энергоэффективности и снижения утечки энергии. А рост интереса к системам-на-чипе (SOC) придает все большее значение созданию широкого спектра устройств на одной микросхеме, из высокопроизводительных транзисторов с ультра-низким уровнем утечки.

Радикальные новые подходы

Историческая перспектива очень важна, потому что она напоминает нам, что единственной постоянной в нашей отрасли является изменение (или, как выразился Йоги Берра, «будущее — это не то, что это было»). В будущем радикально новая архитектура может создать еще один колоссальный сдвиг, когда постепенное улучшение перестает работать. Существует много потенциально привлекательных вариантов технологий вроде туннельных полевых транзисторов, BISFET (bilayer pseudospintronic field-effect transistors) транзисторов, полевых транзисторов на основе графена, и полевых транзисторов на основе спина. Все они активно исследуются в ведущих полупроводниковых компаниях.

Еще одним трендом, который приобретает все большее значение, является более тесная интеграция технологических процессов, дизайна и архитектуры продуктов. За последние несколько поколений, ограничения в процессе масштабирования привели к ограничениям в дизайне, которые, в свою очередь, требуют более тесной совместной оптимизации между дизайном и процессом для достижения лучшего результата. Эта тенденция, вероятно, сохранится и даже будет расти. Будущее будет включать в себя интеграцию новых процессов, дизайна и архитектуры, такие как 3D упаковку внутри чипа, а не только внутри TSV(through-silicon via) упаковки и новых подходов к вычислениям, таких как техпроцесс, оптимизированный для не-булевой логики.

Вполне возможно, что новая архитектура техпроцесса завтра сделает настолько же сильный рывок, что «сегодняшний Феррари» станет выглядеть как древний «конный экипаж». Поскольку мы живем и работаем в это удивительное время для полупроводниковой промышленности, и мы надеемся увидеть еще 50 лет «работы» закона Мура.