| Статистика |

Онлайн всего: 1 Гостей: 1 Пользователей: 0 |

|

Закон VAL'a

ГЛОССАРИЙ

ИНС - Искусственные Нейронные Сети.

ИТ – Информационные технологии.

КМОП - комплементарный металлооксидный полупроводник.

ВВЕДЕНИЕ

Алексей Шаров и Ричард Гордон показали, что экспоненциальный рост сложности самых разных систем вызван положительной обратной связью, а закон Мура – более общее явление, наблюдаемое не только в индустрии ИТ.

В оригинале закон Мура постулирует плотность упаковки транзисторов, а следовательно и сложность полупроводниковых интегральных микросхем, удваивается примерно за 18 месяцев. Закон поражает любого наблюдателя сохранением своей справедливости уже на протяжении шестидесяти лет, но, обобщая этот закон, можно сказать, что он описывает динамику эволюции вообще всех сложных систем, включая и биологические.

Экспоненциальный рост присущ всем системам с положительной обратной связью (dx/dt=cx). Так, в соответствии с законом Мальтуса, численность популяций живых организмов растет экспоненциально, пока ресурсов достаточно для всех. Оказывается, эволюция сложности тоже основана на положительной обратной связи – чем выше генетическая сложность, тем быстрее она растет. Известны, по крайней мере 3 механизма такого рода положительной обратной связи. Во-первых, существующие гены выполняют функции, которые полезны для вновь появившихся, поэтому вероятность сохранения новых генов возрастает с увеличением общей сложности. Во-вторых, новые гены, как правило, возникают как копии – или комбинации – существующих. А в-третьих, сложные геномы обеспечивают большое разнообразие потенциальных функциональных ниш, которые могут быть заняты новыми генами. Похожие механизмы положительной обратной связи вызвали экспоненциальный рост компьютерных технологий. Плотность транзисторов в законе Мура – лишь удобный количественный критерий, оценивающий сложность в ИТ. Закон Мура в такой форме не вечен, поскольку плотность транзисторов ограничена физическими пределами. Тем не менее сложность компьютеров и роботов будет продолжать расти такими же темпами, но за счет других факторов (параллельность, обучаемость и т.п.).

Исследователи в университетах и коммерческих компаниях, занимающихся проектированием процессоров, ищут новые материалы на смену кремнию и разрабатывают передовые производственные технологии. Для практического внедрения новых решений понадобится немало времени, и производителям чипов сегодня приходится полагаться на существующие технологии (например, КМОП), которым в обозримом будущем реальной замены не предвидится.

«КМОП – надежный, проверенный временем вариант, - считает Роберт Колуэлл. Сейчас есть всего две три альтернативные технологии, достаточно многообещающие. И им тяжело будет соперничать с КМОП».

Добиться увеличения производительности можно было бы за счет использования новых материалов, фотоники, оптики и трехмерных компонентов, в которых транзисторы размещались бы друг над другом.

НЕЙРОННАЯ СЕТЬ

Нейронная сеть — термин, имеющий два значения:

1. Биологическая нейронная сеть — сеть, состоящая из биологических нейронов, которые связаны или функционально объединены в нервной системе. В нейронауках зачастую определяется как группа нейронов, которые выполняют специфические физиологические функции.

2. Искусственная нейронная сеть — сеть, состоящая из искусственных нейронов (программируемая конструкция, имитирующая свойства биологических нейронов). Искусственные нейронные сети используются для изучения свойств биологических нейронных сетей, а также для решения задач в сфере искусственного интеллекта.

Ученые из Google сформировали внушительную нейронную сеть. Спустя несколько серий экспериментов сеть стала интересоваться котами. Полученные результаты работы ученые опубликовали в одном из научных изданий. Стоит заметить, что существующие на сегодняшний день алгоритмы машинного обучения базируются на анализе множества экспериментальных данных. Так, чтобы натренировать систему на визуальное распознание авто на фото, необходимо загрузить в нее множество фотографий, которые обозначены как «автомобиль». Подобные системы используются для анализа изображений, распознавания речи, для программ, помогающих проводить проверку сообщений в интернете на спам.

БАЗОВЫЕ АРХИТЕКТУРЫ НЕЙРОННЫХ СЕТЕЙ

Рисунок 1

ИНС может рассматриваться как направленный граф со взвешенными связями, в котором искусственные нейроны являются узлами. По архитектуре связей ИНС могут быть сгруппированы в два класса: сети прямого распространения, в которых графы не имеют петель, и рекуррентные сети, или сети с обратными связями. В наиболее распространенном семействе сетей первого класса, называемых многослойным персептроном, нейроны расположены слоями и имеют однонаправленные связи между слоями. На рисунке 1 представлены типовые сети каждого класса. Сети прямого распространения являются статическими в том смысле, что на заданный вход они вырабатывают одну совокупность выходных значений, не зависящих от предыдущего состояния сети. Рекуррентные сети являются динамическими, так как в силу обратных связей в них модифицируются входы нейронов, что приводит к изменению состояния сети.

История исследований нейронных сетей

Основы теории нейронных сетей были независимо разработаны А.Бэйном (1873) и У.Джеймсом (1890). В своих работах они рассматривают мыслительную деятельность как результат взаимодействия между нейронами в головном мозге.

Согласно Бэйну, любая деятельность ведёт к активизации определенного набора нейронов. При повторении той же деятельности связи между этими нейронами укрепляются. Согласно его теории, эти повторения ведут к формированию памяти. Научное сообщество того времени восприняло теорию Бэйна скептически, поскольку следствием её являлось возникновение чрезмерного количества нейронных связей в мозге. Теперь очевидно, что мозг является чрезвычайно сложной конструкцией и способен работать с несколькими задачами одновременно.

Теория Джеймса была схожа с теорией Бэйна, но в то же время Джеймс предположил, что формирование памяти происходит в результате прохождения электрических токов между нейронами в головном мозге, не требуя соединений нейронов для каждого акта запоминания или действия.

Британский физиолог Ч.Шеррингтон в 1898 провел эксперименты для проверки теории Джеймса. Он пропускал электрический ток вдоль спинного мозга крыс. При этом вместо ожидаемого усиления тока, согласно теории Джеймса, Шеррингтон обнаружил, что электрический ток ослабевает с течением времени. Результаты экспериментов Шеррингтона сыграли важную роль в разработке теории привыкания.

В 1943 Мак-Каллок и Питтс разработали компьютерную модель нейронной сети на основе математических алгоритмов. Они назвали эту модель «пороговой логикой». Модель Мак-Каллока — Питтса заложила основы двух различных подходов исследований нейронных сетей. Один подход был ориентирован на изучение биологических процессов в головном мозге, другой — на применение нейронных сетей для искусственного интеллекта.

В конце 1940-х канадский физиолог и психолог Дональд Хебб выдвинул гипотезу интерпретации обучения на основе механизма нейронной пластичности, известную как теория Хебба. Теория Хебба считается типичным случаем самообучения, при котором испытуемая система спонтанно обучается выполнять поставленную задачу, без вмешательства со стороны экспериментатора. В более поздних вариантах теория Хебба легла в основу описания явления долговременной потенциации. Эти идеи с 1948 начали применяться для вычислительных моделей в B-машинах А.Тьюринга.

Фарли и Кларк в 1954 с использованием компьютеров разработали имитацию сети Хебба в Массачусетском технологическом институте. Другие исследования нейронных сетей с помощью компьютерного моделирования были проведены в 1956 Рочестером, Холландом, Хебитом и Дуда.

В 1957 Ф.Розенблатт разработал персептрон — математическую и компьютерную модель восприятия информации мозгом, на основе двухслойной обучающей компьютерной сети, использующей действия сложения и вычитания. В математической нотации Розенблатт описал также схему не только основного перцептрона, но и схему логического сложения, которая не могла быть реализована до разработки в 1975 Вербосом метода обратного распространения ошибки.

Исследования нейронных сетей застопорились после публикации работы по машинному обучению Минского и Пейперта в 1969. Они обнаружили две основные проблемы, связанные с вычислительными машинами, которые обрабатывают нейронные сети. Первая проблема состояла в том, что однослойные нейронные сети не могли совершать логическое сложение. Второй важной проблемой было то, что компьютеры не обладали достаточной вычислительной мощностью, чтобы эффективно обрабатывать огромный объём вычислений, необходимых для больших нейронных сетей. Исследования нейронных сетей замедлились до того времени, когда компьютеры достигли больших вычислительных мощностей. Одним из важных более поздних достижений было открытие метода обратного распространения ошибки, который позволил решить проблему с логическим сложением.

Когнитрон, разработанный К.Фукусимой в 1975, был одной из первых многослойных нейронных сетей с алгоритмом обучения. Фактическая структура сети и методы, используемые в когнитроне для задания относительных весов связей, варьировались от одной стратегии к другой, каждая из стратегий имела свои преимущества и недостатки. Сети могли распространять информацию только в одном направлении, или перебрасывать информацию из одного конца в другой, пока не активировались все узлы и сеть не приходила в конечное состояние. Достичь двусторонней передачи информации между нейронами/узлами удалось лишь в сети Хопфилда (1982), и специализация этих узлов для конкретных целей была введена в первых гибридных сетях.

ГОЛОВНОЙ МОЗГ, НЕЙРОННЫЕ СЕТИ И КОМПЬЮТЕРЫ

Нейронные сети, используемые в сфере искусственного интеллекта, традиционно рассматриваются как упрощенные модели нейронных сетей в головном мозге, хотя вопрос о том, в какой мере искусственные нейронные сети отражают реальную структуру головного мозга, по-прежнему остается открытым.

Предметом исследований в теоретической нейробиологии является вопрос об уровне сложности и свойствах, которыми должны обладать отдельные нейроны для того, чтобы воспроизвести нечто, похожее на разум животных.

Исторически сложилось, что развитие компьютерной техники шло от архитектуры фон Неймана, которая основана на последовательной обработке и исполнении явных инструкций. С другой стороны, разработка искусственных нейронных сетей основывалась на моделях обработки информации в биологических системах, которые предполагают параллельную обработку информации, а также использование неявных инструкций на основе распознавания «сенсорных» входов из внешних источников. Другими словами, нейронная сеть представляет собой сложный статистический процессор (в отличие от систем, основанных на последовательной обработке и исполнении команд).

Нейрокодирование основано на том, как нейроны представляют сенсорную и другую информацию в мозге. Основная цель изучения нейрокодирования — выявить характер связи между стимулом и индивидуальной или групповой реакцией нейронов на него, а также взаимосвязь между электрической активностью нейронов в группе. Считается, что нейроны могут кодировать как цифровую, так и аналоговую информацию.

НЕВРОЛОГИЯ

Рисунок 2

Комментарий к рисунку 2: части нервной клетки, или нейрона. Каждый нейрон состоит из тела клетки (или сомы), которое содержит ядро клетки. От тела клетки ответвляется множество коротких волокон, называемых дендритами, и одно длинное волокно, называемое аксоном. Аксон растягивается на большое расстояние, намного превышающее то, что показано в масштабе этого рисунка. Обычно аксоны имеют длину 1 см (что превышает в 100 раз диаметр тела клетки), но могут достигать 1 метра. Нейрон создает соединения с другими нейронами, количество которых может составлять от 10 до 100 000 в точках сопряжения, называемых синапсами. Сигналы распространяются от одного нейрона к другому с помощью сложной электрохимической реакции. Эти сигналы управляют активностью мозга в течение короткого интервала, а также становятся причиной долговременных изменений состояния самих нейронов и их соединений. Считается, что эти механизмы служат в мозгу основой для обучения. Обработка информации главным образом происходит в коре головного мозга, которая представляет собой самый внешний слой нейронов мозга. По-видимому, основной структурной единицей является столбец ткани, имеющий диаметр около 0,5 мм и протяженность на всю глубину коры, толщина которой в человеческом мозгу составляет около 4 мм. Каждый столбец содержит примерно 20 000 нейронов.

Закон VAL’a

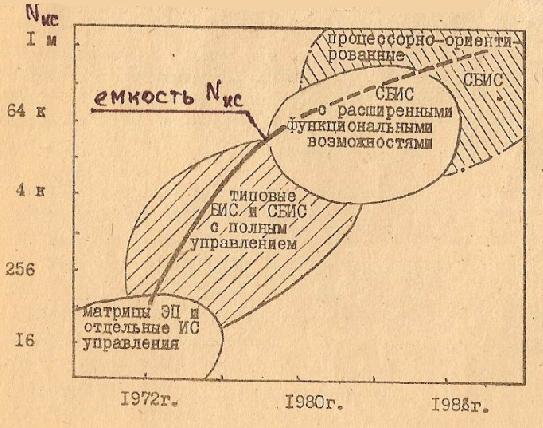

За истекшие 27 лет (с момента защиты ВАЛом диссертации на кафедре «Микроэлектроники» МИФИ в 1981 году на тему полупроводниковой памяти с «интеллектом или о процессорно-ориентированных СБИС памяти) технологии в области микроэлектроники, компьютеров и компьютерных сетей «бешено ринулись вперед, что можно увидеть на рисунке 3.

Рисунок 3

Технологии волоком увлекают людей за собой, «умудряясь при этом погонять их не только криками» и пинками, но и растущим интеллектом буквально во всем: в элементной базе компьютеров, в самих компьютерах, в сетях этих компьютеров.

Нет ничего удивительного, что кроме рождения Закона Мэрфи (и Мерфологии) обязательно должен появиться и позитивный закон, например, закон ВАЛа и наука ВАЛиология… Иначе говоря не предвидится ближайшего конца развития.

ВАЛиология (ВАЛ/и + логия [logos – наука; lego – говорить, собирать]) – 1) отрасль знании, посвященная тому, что, что все идет по нарастающей, в лучшую сторону к всеобщему интеллекту, о котором можно было только мечтать; 2) наука о расширении интеллектуальных возможностей элементной базы компьютеров, компьютеров и сетей на их основе; 3) собирание пословиц, поговорок, афоризмов, максим и иных высказываний в данной области, а также их публичное распространение во всемирной сети.

На рисунке 4 можем увидеть, что закон ВАЛа экспоненциально больше, и значит что всплеск прогресса больше. Остается только узнать периоды таких всплесков, т.е. что нас ждет впереди.

Рисунок 4

Заключение по работе

Пока существуют ученые и специалисты будет развиваться технология во всех отраслях, и в то время когда перестанет действовать закон Мура (на одном кристалле не может разместиться более одного транзистора) в силу вступит закон VAL'a, поменяется технология в корне и быстродействие вычислительной техники будет развиваться дальше.

Список литературы

1. http://www.aiportal.ru/articles/introduction/prehistory-ai-part4.html

2. http://www.valinfo.ru/forum/index.php?showtopic=1987

3. http://de.ifmo.ru/bk_netra/page.php?tutindex=25&index=44&layer=2

4. http://neurogene.ru/nejronnoj-seti-google-udalos-raspoznat-kotov

5. http://ru.wikipedia.org

6. Журнал «Открытые системы» издание №5, 2013, www.osmag.ru

7. Журнал «Computerworld» издание № 26(811), 22.10.2013, www.computerworld.ru |

| Категория: Конспекты (курсы КП и ПК) | Добавил: eNR (20.12.2013)

|

| Просмотров: 1814

| Рейтинг: 0.0/0 |

Добавлять комментарии могут только зарегистрированные пользователи. [ Регистрация | Вход ] |

|